整体设计

整个hardCore的进程部分由uCore扩展而来,我们主要扩展的目标有以下几个:

- 实现对内核线程的支持,使得用户态可以使用多线程

- 扩展OS支持的调度算法:

- 基于红黑树实现linux2.6版本中经典进程调度器CFS

- stride调度器

- RR调度器

- 增加用户态的信号量支持,搭配内核线程在用户态实现生产者消费者,读者写者等经典线程同步算法

- 提高OS进程的可靠性,在用户态因为爆栈等错误退出的时候不会导致OS崩溃

- 实现top等用户命令,扩展shell功能支持用户态进程后台执行

当前已经实现了内核态进程以及CFS调度器,下文详细的阐述了这两个部分的实现过程,下一阶段主要想实现的内容就是信号量以及用户态程序的支持,从而构建一个完整的OS。

用户态内核进程实现

linux 实现参考

How Stack or memory is allocated for threads under the same process in Linux

The current ‘thread’ concept in Linux is the NPTL one. NPTL usesclone(), which wrapssys_clone(). Allocating a stack for a new ‘thread’ is handled in the user space (ie. libc), not in kernel (ie. Linux). A library can allocate a stack using the allocation of choice (eg.malloc) and then callclone()passing this address as the stack (of course, needs to pass the top of the allocated region, since stacks grow downwards on most platforms):

Unlikefork(),clone()allows the child process to share parts of its execution context with the calling process, such as the memory space, the table of file descriptors, and the table of signal handlers….

The main use ofclone()is to implement threads: multiple threads of control in a program that run concurrently in a shared memory space.

When the child process is created withclone(), it executes the functionfn(arg)…

The child_stack argument specifies the location of the stack used by the child process …

If you want to learn more specific details, open the source of your distropthread_createimplementation and get reading.

For examplepthread_create.c:

1 | int |

andallocatestack.c:

1 | # define ALLOCATE_STACK(attr, pd) allocate_stack (attr, pd, &stackaddr) |

You’ll see that stack allocation has some whistles and bells, like caching and reusing stack regions, guard pages, but in the end is just a memory region allocated in user space.

uCore 实现

在 linux 中,thread 通过 clone 调用实现,但是分配栈空间是用户空间关心的事,比如使用 malloc 申请之类的。

在 uCore 中并没有实现用户态的 malloc,所以暂时无法使用 malloc 在堆区为一个新的进程开辟一个栈空间,但这并非就是无法实现进程。

于是我们换了另外一种方式就是挪用调用 clone 进程的栈空间。linux 默认为每个进程分配 1M 的栈空间,一旦某个进程调用 clone,我们将该调用进程 1M 的栈空间等分为 16 份,取出一块空闲的栈空间分配给该子线程。针对可能出现递归调用 phthread_create 的情况,不断向上找到第一个调用 clone,然后栈被分割成 16 份的进程,从该进程处获取栈空间。

子线程退出时会向该进程归还所使用的栈空间,所以包含该第一个调用 clone 的进程在内(下文统一称为祖宗线程),同一时间进程里可以存在 16 个线程。

PCB 支持

在 PCB 中增加以下三个变量用于支持内核线程

| Type | name | meaning |

|---|---|---|

| int | is_thread | 标志该进程是否是一个子线程 |

| int | stack_num | 标志该子线程占用了父进程的哪一个栈帧,is_thread = 1 才有效 |

| int [ ] | stack[MAX_THREAD] | 每个主进程能够开启 16 个线程(包括主线程(自己)在内),每个块为 0 表示该块的栈没有被占用,不为 0 表示被占用,且值是该子线程的 pid |

特别说明只有祖宗线程和普通进程 is_thread 为 0,其他子线程该值都是 1。

clone 调用

1 | int do_clone(void *(*fn)(void *), void *arg, void (*exit)(int)) |

注意因为用户有可能不会在线程执行的函数结束返回时调用 exit,所以 clone 的一个任务就是帮助用户将线程栈栈底的返回地址设置为 sys_exit (不是直接 do_exit 因为该线程执行在用户态,只有通过系统调用才能执行内核态代码)

最后的线程栈栈帧如图所示

祖宗线程 exit 时守护

若祖宗线程没有调用 join 来等待子线程结束工作,祖宗线程会直接退出,虽然这样内存空间的引用计数不为 0,不会释放他们共用的内存空间,剩余线程还能继续执行,但是所有栈的分配信息都存在祖宗线程的 PCB 表中,如果祖宗线程一旦释放,子进程再想调用 phthread_create 新建子进程会导致失败。于是必须在祖宗线程调用 sys_exit 时守护所有子线程退出后祖宗线程才能退出。

1 | static int |

线程一致性维护

linux 上的线程就是基于轻量级进程, 由用户态的 pthread 库实现的.使用 pthread 以后, 在用户看来, 每一个 task_struct 就对应一个线程, 而一组线程以及它们所共同引用的一组资源就是一个进程。但是, 一组线程并不仅仅是引用同一组资源就够了, 它们还必须被视为一个整体。当”进程”收到一个致命信号(比如由于段错误收到 SIGSEGV 信号), 对应的这一组 task_struct 将全部退出。这是 POSIX 对线程实现提出的要求,如果某个线程”挂”了, 整个进程还在若无其事地运行着, 可能会出现很多的不一致状态. 进程将不是一个整体, 而线程也不能称为线程。

在 uCore 中我们也实现了该线程的一致性

1 | case T_PGFLT: //page fault |

比如有一个线程缺页异常的话,对应的这组进程都会被杀死。

CFS进程调度实现

其他两个调度器的实现比较简单,这里主要研究CFS调度器是如何实现的

CFS调度器介绍

cfs 定义了一种新的模型,它给 cfs_rq(cfs的run queue)中的每一个进程安排一个虚拟时钟,vruntime。如果一个进程得以执行,随着时间的增长(也就是一个个tick的到来),其vruntime将不断增大。没有得到执行的进程vruntime不变。而调度器总是选择vruntime跑得最慢的那个进程来执行。这就是所谓的“完全公平”。为了区别不同优先级的进程,优先级高的进程vruntime增长得慢,以至于它可能得到更多的运行机会。

如果分配给进程的运行时间不等于实际运行的时间时:CFS的思想就是让每个调度实体的vruntime增加速度不同,权重越大的增加的越慢,这样高优先级进程就能获得更多的cpu执行时间,而vruntime值较小者也得到执行。

每一个进程或者调度组都对应一个调度的实体,每一个进程都通过调度实体与CFS运行对列建立联系,每次进行CFS调度的时候都会在CFS运行对列红黑树中选择一个进程(vruntime值较小者)。cfs_rq代表CFS运行对列,它可以找到对应的红黑树。进程task_struct ,可以找到对应的调度实体。调度实体sched_entity对应运行对列红黑树上的一个节点。

调度器实现

运行队列中的进程/线程会频繁进行插入和删除。为了效率考虑,CFS调度队列我们需要使用红黑树来实现,每次选择最小vruntime的节点执行(即选择这颗红黑树上的最左节点)将其从这颗红黑树中删除,调度到CPU上执行。因为C语言中没有提供面向对象的编程方法,我们借用linux内核中提供的红黑树的基础库来实现我们自己的cfs红黑树。简单介绍一下linux内核里的红黑树。

Linux有很多地方用到了红黑树,比如高精度计时器使用红黑树树组织定时请求,EXT3文件系统也使用红黑树树来管理目录,虚拟存储管理系统也有用红黑树树进行VMAs(Virtual Memory Areas)的管理。Linux内核红黑树的实现与传统的实现方式有些不同,它对针对内核对速度的需要做了优化。每一个rb_node节点是嵌入在用RB树进行组织的数据结构中,而不是用rb_node指针进行数据结构的组织。对于CFS运行队列这颗红黑树的节点 cfs_node,我们只要在里面内嵌一个 rb_node 节点再加一个指向该进程PCB的指针,我们就可以利用linux提供的红黑树操作函数来封装出一个我们自己的CFS调度队列。

对于一个挂在CFS队列里面的进程,我们需要实现的方法有

1 |

|

一个节点的插入和删除,找最小(就是找最左子节点),还有节点值的大小比较。这里值得关注的函数就是节点值大小比较。在 linux 中的红黑树中,若两个节点的 value 大小相等会放弃插入,但是连续插入的两个 vruntime 很可能相同,针对这种情况,重新规定红黑树的排序规则

vruntime 不同时比较 vruntime ,vruntime大者大。vruntime 相同时比较 pid ,pid大者大. 因为树里面不可能有两个相同的进程,所以该排序可以保证线序关系。

下面简单的去实现这个红黑树节点的方法

1 | int compare_cfs_node(struct proc_struct *a, struct proc_struct *b) |

下面开始实现CFS调度器

首先是调度器初始化函数, 初始化红黑树根节点,并设置调度队列里面的进程数量为0

1 | static void |

之后是插入进程,将进程插入红黑树,并且增加该进程里面的进程数量

1 | static void |

然后是把一个待运行的进程从运行队列里面出队,根据PCB找到CFS节点数据结构的位置。销毁创建的CFS节点,减少进程计数。

1 | static void |

然后是每一次时钟中断的调用,这里是我们实现的时候与 linux 实现不一样的地方。在标准linux 的实现中,若当前运行的 proc 的 vruntime 已经不是队列里面最小的了(实际上会导致频繁调度,所以一般设置一个阈值)超过这个限制会直接触发调度,但是我们为了简单和一定程度上的效率考虑只是通过 vruntime 进行选择,而不是使用 vruntime 进行抢占调度。

1 | static void |

对一些问题的研究

用户态进程是如何退出的

以 stackOverflow.c 这个程序为例, 在编译的时候总共涉及 gcc 的调用和 ld 的链接操作

1 | gcc -Iuser/ -fno-builtin -fno-PIC -Wall -ggdb -m32 -gstabs -nostdinc -fno-stack-protector -Ilibs/ -Iuser/include/ -Iuser/libs/ -c user/stackOverFlow.c -o obj/user/stackOverFlow.o |

之所以选这个程序是因为简单,使用 objdump 反汇编第一条 gcc 编译指令执行完毕生成的 stackOverFlow.o 文件的 text 段如下所示:

注意现在还没有到链接的阶段,所有 text 段代码的起始位置都是 0 地址处:

1 | Disassembly of section .text: |

下一条链接指令会将 user/lib 下的所有 .o 文件与 stackOverFlow.o 一起进行链接操作

其中链接的 obj/user/libs/initcode.o 是一段汇编代码

1 | .text |

结合链接脚本中的ENTRY(_start)可知在链接完成后 initcode.o 是最先被执行的,该段汇编指令调用了 umain 函数,定义在 umain.o 里。

umain 打开了输入输出流两个文件描述符,并调用函数 main (注意:umain 上面的 main 函数只是声明,在链接的时候会把 stackOverFlow.o 里面的 main 函数实现给链接上,main 函数执行完成后 umain 调用系统调用 exit 退出)

1 | int main(int argc, char *argv[]); |

截取几段链接完成后的反汇编代码

1 | Disassembly of section .text: |

可以看到代码段真如 ld 脚本规定的从 0x00800020 地址处开始

1 | 0080066b <_start>: |

最后操作系统在执行这段代码的时候会根据 elf 的格式将 eip 设置为 0x0080066b 从这开始执行。

为何代码不从 0 地址开始

The stack, which is usually quite small but could grow quite dramatically in some occasions. The stack grows down, and when the stack is full, we really want the process to predictably crash rather than overwriting some data. So there had to be a wide area for the stack, with, at the low end of that area, an unmapped page. And lo! There is an unmapped page at address zero, to catch null pointer dereferences. Hence it was defined that the stack would get the first 128 MB of address space, except for the first page. This means that the code had to go after those 128 MB, at an address similar to 0x080xxxxx.

As Michael points out, “losing” 128 MB of address space was no big deal because the address space was very large with regards to what could be actually used. At that time, the Linux kernel was limiting the address space for a single process to 1 GB, over a maximum of 4 GB allowed by the hardware, and that was not considered to be a big issue.

第一个用户进程 sh

第一个用户进程是从int pid = kernel_thread(user_main, NULL, 0);而来。

1 | int |

送了这个即将执行的 user_main 函数一个内核栈帧和一个 kernel_thread_entry 函数(该函数定义 user_main 执行完成后会自动调用 do_wait) 然后就把 user_main 进程给 fork 出来了(此时还在内核态)。

最后 user_main 进程执行了 user_main 函数,引发一个中断调用 exec,把这个进程掏空,该进程变成了进程 sh ,注意在从文件系统载入代码的 load_icode 函数中,在中断栈帧中把 user_main 的段子换成了用户态的段子,只要中断一返回,该进程回到了用户态

虽然上面定义了 user_main 执行完成后会自动调用 do_wait ,但一个 exec 调用过后, eip 指针的值已经被修改,sh 已经和 kernel_thread_entry 没关系了。 所以最后 sh 若要退出需要通过中断调用(用户进程也没法直接执行 do_wait), 具体如何进行的中断调用仍需要研究。

对 top 指令的结果分析

进程数量等于 os 内的全局变量 nr_process 这个变量包含了 idle 进程所以总共 4 个没问题。

init 进程从其创建,第一次执行 do_wait 的时候,就因为其有 user_main(该进程创造 sh 后结束) 这个进程而陷入了 sleep ,只要其子进程(sh)不死(就是变 Zombie,sleep 都没用),永远不会唤醒该 init 进程来回收资源(其他父线程托孤的时候可能唤醒 init)。

1 | while (do_wait(0, NULL) == 0) { |

idle 的调度是被特判过的, 运行队列里面没有 idleproc , OS 在没有进程可供调度的时候选择进程 idleproc,自然其 vruntime 不会被计算

1 | static void |

sh 是在等待输入的函数dev_stdin_read主动调用schedule()放弃时间片,所以 在间隔两次输入top指令的中间,sh 一直在等待输入,并没有被调度,所以两次间隔后 idle 的调度次数会巨多因为除了 idle ,ucore 没有其他进程可供调度,但 vruntime 是 0(因为特判),sh 的 vruntime 可能会有小幅 提升因为调用了 top ,中间处理会给 sh 时间,但一旦 top 开始执行, sh 又会因为等 top 执行完毕被挂起,top 执行完成后又在等输入。。。。

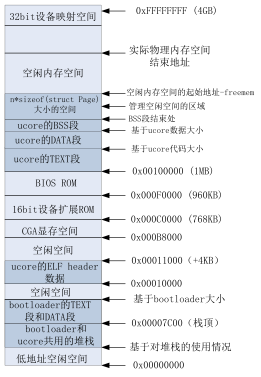

对用户栈的研究

每个用户进程都设置了用户栈为,栈顶是 USTACKTOP - 1 (第一个地址不是),栈大小是 USTACKSIZE 。调用 mm_mmap 函数建立用户栈的 vma 结构,明确用户栈的位置在用户虚空间的顶端,大小为 256 个页,即 1MB。但这个只是设置了 vma 。下面调用 pgdir_alloc_page 分配了 4 页(16KB)的栈空间给用户。

1 | vm_flags = VM_READ | VM_WRITE | VM_STACK; |

一旦这 4KB 的栈被用完了,那么就会引起缺页异常。

1 | struct vma_struct *vma = find_vma(mm, addr); |

因为 vma 里写的是 1MB 空间,实际只分配给了 16KB ,缺页的时候只要地址在 1MB 的范围内,那么 通过缺页的地址是找得到对应的 vma 的,说明这个是个合法地址,os 会自动根据缺页地址新建页表项并分配 page 。当栈的使用超过 1MB,就会找不到 vma 直接报错,这个行为目前会直接崩掉内核,可用考虑后续的优化。

时钟中断

1 | //设置时钟每秒中断100次 |

每 1s 中断 100 次则一个时间片的时长为 10ms , usleep(100) 睡眠 1s。